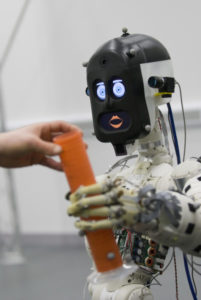

BERT2، إنسالي (روبوت) مساعِد بشري الشكل، يقدم شيئًا إلى إنسان حقيقي.

حقوق الطبع: مختبر الإنساليات (الروبوتيات Robotics) لجامعة بريستول البريطانية.

إن صنع شريك على هيئة إنسالي، أو إنسان آلي، (روبوت Robot) قادر على التعبير والتواصل وتقديم المساعدة هو أمر من المرجح أن يجعل هذا الروبوت أكثر مسرةً للعمل معه وأن يؤدي إلى أن يثق المستخدمون به بشكل أكثر، حتى وإن ارتكب بعض الأخطاء، كما تقترح دراسة جديدة في هذا المضمار.

ألا أن الأبحاث تُظهر أيضًا بأن إضفاء بعض السمات البشرية على الروبوتات قد يكون له جانب سلبي – فقد يقوم المستخدمون بالكذب أحيانًا على الروبوت لتفادي إيذاء مشاعره.

أجرى باحثون من كلية لندن الجامعية وجامعة بريستول البريطانية تجربة عبر إنسالي (روبوت) مساعِد بشري الشكل لمساعدة المستخدمين على إعداد وجبة (أومليت) البيض. تم تكليف الروبوت بتمرير البيض والملح والزيت ألا أنه أسقط إحدى البيضات (المصنوعة من البوليستيرين) في حالتين من الحالات ومن ثم حاول على إجراء تعديلات على طريقة عمله.

كان الهدف من الدراسة هو التحقيق حول كيف بإمكان الروبوت أن يستعيد ثقة المستخدمين به عندما يرتكب خطأً ما وكيف بإمكانه الإعلام عن سلوكه الخاطئ لشخص يعمل معه، سواء في المنزل أو في مكان العمل.

تقترح الدراسة بأن أكثرية المستخدمين يفضلون إنساليًا (روبوتًا) كان قادرًا على التواصل والتعبير بدلًا من روبوت أكثر فعالية وكفاءة وأقل ارتكابًا للأخطاء، مع أن الروبوت الذي كان قادرًا على التواصل والتعبير أخذ وقتًا أطول بنسبة 50% لإنجاز المهمة ذاتها.

تلقى المستخدمون بشكل طيّب الاعتذار الصادر من الروبوت الذي كان قادرًا على التواصل، وشعروا بالتقدير على وجه التحديد إزاء تعبير الروبوت عن الحزن على ملامح وجهه. قال الباحثون بأن هذا الأمر من المرجح أن يكون قد أعطاهم توكيدًا لهم بأن الروبوت “عرف” بأنه قد ارتكب خطأً ما.

وفي نهاية العملية التفاعلية، تمت برمجة الروبوت القادر على التواصل لكي يسأل المشاركين عمّا إذا كان بإمكانهم أن يكلفوه بالقيام بمهمة المساعِد المطبخي، ولكن كان بمقدور المستخدمين أن يجيبوا إما بنعم أو لا فقط، دون المقدرة على تبرير أجوبتهم للروبوت.

تردد بعض المستخدمين بالإجابة وبدا بعضهم غير مرتاحٍ. فقد كان لدى أحدهم انطباع بأن الروبوت بدا حزينًا عندما أجابه المستخدم بـ “كلا”، بينما في الحقيقة لم يكن الروبوت مبرمجًا للظهور بمظهر الحزن في مثل هذه الحالة. وقد اشتكى مستخدم آخر من وجود ابتزاز عاطفي، بينما ذهب مستخدم ثالث إلى أبعد من ذلك من خلال الكذب على الروبوت نفسه.

قالت أدريانا هاماشير، التي أجرت الدراسة كجزء من متطلبات شهادة ماجستير العلوم الخاصة بها في مجال التفاعل الإنساني الحاسوبي (Human Computer Interaction) بكلية لندن الجامعية: “نقترح أنه عند مشاهدتنا لما أظهره الروبوت من عاطفة شبيهة بالعاطفة البشرية عند سقوط البيضة، فقد أصبح الكثير من المشاركين مستعدين مسبقًا لتوقع رد فعل مماثل بالمرات اللاحقة وبالتالي فقد ترددوا بالإجابة بـ “كلا”؛ فقد كانوا على علم باحتمال أن يُظهر الروبوت علامة استياء أخرى شبيهة بردود الأفعال البشرية.”

“قد تكون بعض السمات الشبيهة بالسمات البشرية، كالندم مثلًا، أدوات قوية في التعبير عن عدم الرضا، ولكن علينا أن نحدد بعناية ما هي السمات التي نريد التركيز عليها ومن ثم نسخها إلى الروبوتات. إذا لم تكن هنالك قواعد للعمل على أرض الواقع، فقد ينتهي المطاف بنا في الحصول على روبوتات بشخصيات مختلفة، كشخصيات الأشخاص العاملين على تصميمها.”

أما البروفيسور كيرستن إيدر، والذي يقود المجموعة البحثية المعنية بموضوع التحقق والتأكيد (Validation and Verification) للسلامة في الروبوتات في مختبر الروبوتيات بجامعة بريستول البريطانية، والذي شارك في الإشراف على مشروع أدريانا، فقد قال: “ثقتنا في نظرائنا أمر أساسي لضمان التفاعل الناجح. تقدم لنا دراسة أدريانا رؤى جوهرية في بيان كيف بإمكان تعابير التواصل والتعابير العاطفية من الروبوتات أن تعمل على التخفيف من حجم السلوك غير المتوقع في علم الروبوتيات التعاونية (Collaborative Robotics)، حيث أن الجمع ما بين عملية التحقق والتأكيد المكثفتين وبين الفهم المنطقي لهذه العوامل البشرية هو أمر من شأنه أن يساعد المهندسين على تصميم روبوتات مساعِدة يكون بمقدور الناس الثقة بها.”

وقد تماشى مشروع أدريانا مع مشروع الروبوتات المساعِدة الجديرة بالثقة والذي تم تمويله من قبل مركز أبحاث العلوم الهندسية والفيزيائية (EPSRC) في المملكة المتحدة، والذي يتم فيه تطوير تقنيات جديدة للتحقق والتأكيد لضمان السلامة والموثوقية في الآلات التي من شأنها أن تعمل على تحسين جودة حياتنا في المستقبل.

سيتم عرض هذا البحث في الندوة الدولية جمعية مهندسي الكهرباء والإلكترونيات (IEEE) في الولايات المتحدة، كجزء من أعمال المؤتمر المتوفرة عبر مكتبة (Xplore) الرقمية الخاصة بالجمعية.

مصدر القصة:

تمت إعادة طباعة المقالة أعلاه من المواد المقدمة من قبل جامعة بريستول البريطانية.

المصدر:

https://www.sciencedaily.com/releases/2016/08/160819084651.htm

Iraqi Translation Project لأن عقوداً من الظلام الفكري لا تنتهي إلا بمعرفة الأخر الناح..لابد من الترجمة

Iraqi Translation Project لأن عقوداً من الظلام الفكري لا تنتهي إلا بمعرفة الأخر الناح..لابد من الترجمة